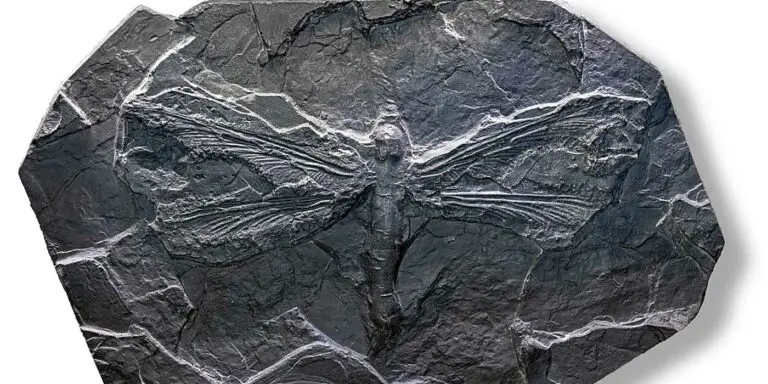

Las Meganeura y el insecto más grande que habitó la tierra

Durante el período carbonífero una mayor concentración de oxígeno y la falta de predadores llevó a la aparición de insectos colosales: las Meganeura.

Durante el período carbonífero una mayor concentración de oxígeno y la falta de predadores llevó a la aparición de insectos colosales: las Meganeura.

Con el fin de estudiar la anatomía de los seres de las profundidades oceánicas, la misión NORFANZ logró capturar algunos de los especímenes abisales más singulares.

Los cuaterniones son un tipo de números hipercomplejos que, entre otras aplicaciones de importancia, generan algunos de los fractales más bellos.

El sol de medianoche es un fenómeno meteorológico y climático en el cual las tierras cercanas al polo norte terrestre pasan meses enteros sin anochecer.

Un grupo de investigadores islandeses ingresó a la cámara magmática del volcán Þríhnúkagígur. Descubriendo una fascinante y gigantesca bóveda natural.

Utilizando cámaras estenopeicas y dejándolas durante meses apuntando al sol, se logran capturar hermosas fotografías del trayecto del sol por el cielo.

Biosphere 2 es el único bosque tropical bajo techo del mundo, no obstante, el ambiente perfecto de sus inicios llevó a que sus árboles sean débiles.

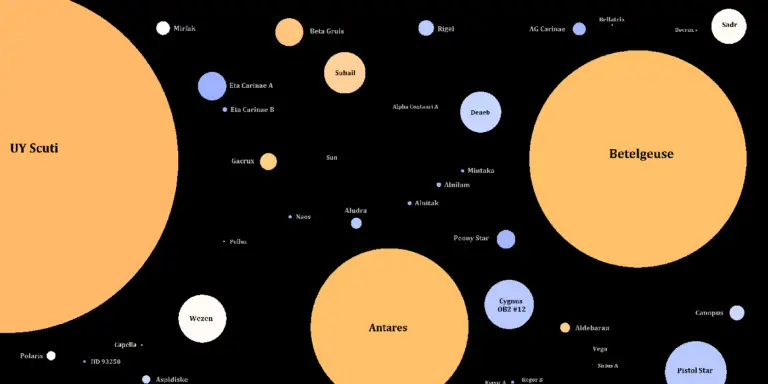

La estrella más caliente en el universo, ubicada constelación de la Quilla, es Eta Carinae, una colosal estrella azul al borde de lo posible.

La Sustancia-N fue una de las "armas de venganza" de los alemanes en la Segunda Guerra. Un poderoso gas venenoso e incendiario capaz de incendiar metales.

A mediados del siglo XX los Laboratorios Bell intentaron algo asombroso: fotografíar el sonido. Esta es la historia de como se logró ver el sonido.

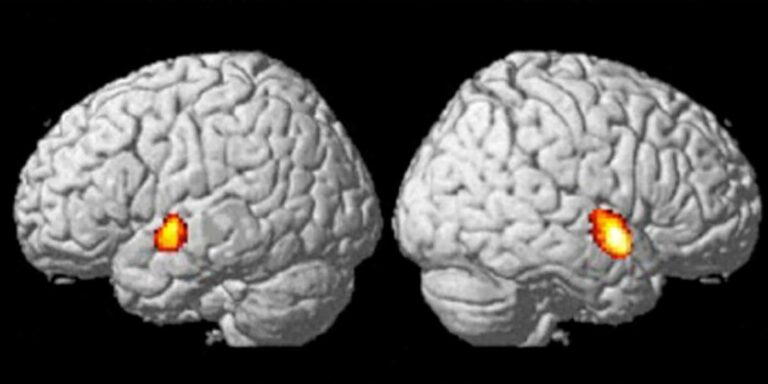

El efecto McGurk es un fenómeno de percepción audiovisual de carácter neurológico que demuestra la asociación entre lo auditivo y las señales visuales.

De la luna se recolectaron 382 kilogramos de rocas lunares. Una de estas, la denominada Sample 61016, fue la roca lunar más grande traída a la tierra.

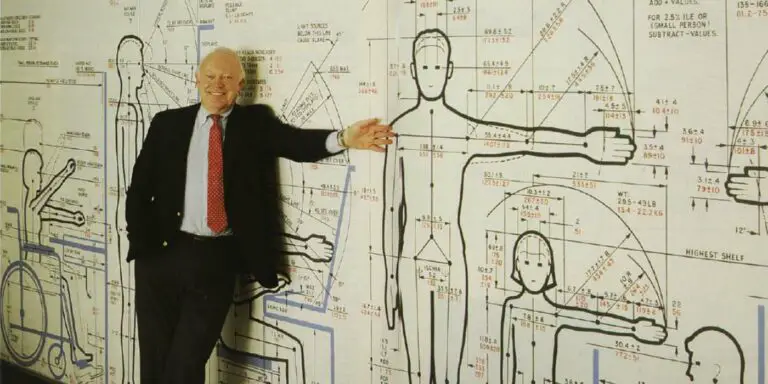

En el siglo XX dos hombre revolucionarían la arquitectura y el diseó industrial. Le Corbusier y Henry Dreyfuss, los padres de la antropometría.