El trineo a cohete de la NASA, el vehículo de tierra rápido de la Historia

Para probar los límites de velocidad terrestre la NASA construyó el vehículo de tierra más rápido de la historia. Un maglev capaz de alcanzar 10.325 km/h.

Para probar los límites de velocidad terrestre la NASA construyó el vehículo de tierra más rápido de la historia. Un maglev capaz de alcanzar 10.325 km/h.

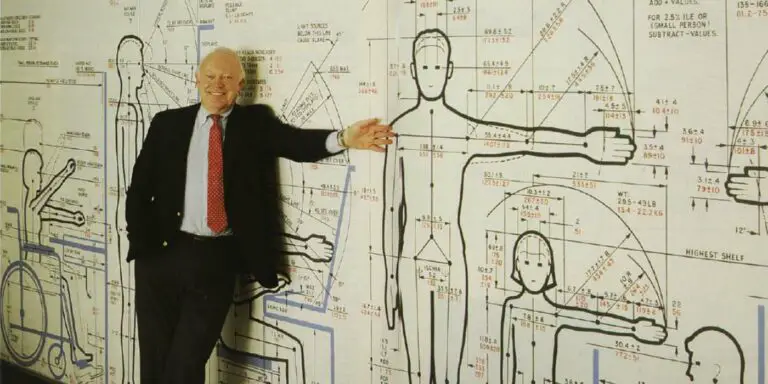

En el siglo XX dos hombre revolucionarían la arquitectura y el diseó industrial. Le Corbusier y Henry Dreyfuss, los padres de la antropometría.

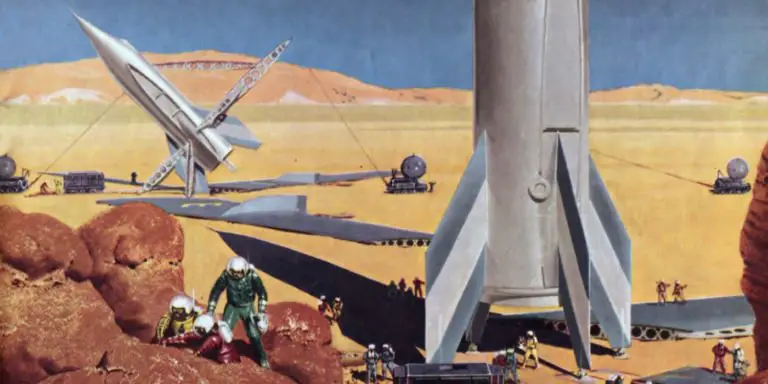

Tras completar las misiones Apolo, Wernher von Braun decidió crear un plan para viajar a marte. El Proyecto MARTE, el plan para ir a Marte.

Gracias al principio de Arquímedes gigantescas moles de acero como los submarinos modernos pueden hundirse y salir a flote.

Desde un sistema de posicionamiento hasta misiles guiados que no se verían nuevamente hasta una década fueron algunas de las armas secretas alemanas de la segunda guerra mundial.

Necesitado de dinero el genio renacentista diseñó un tanque de guerra circular para la familia Sforza. El tanque de Leonardo da Vinci.

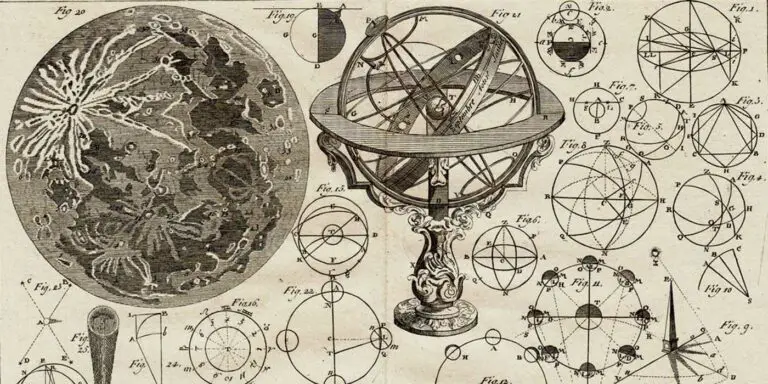

La astronomía de las civilizaciones antiguas es fascinante y rica: de la Mesopotamia y Egipto a Grecia, Roma, los hebreos y China.

La medicina medieval era practicada por herboristas, monjes y doctores. Irónicamente, caer en manos de un doctor medieval era la peor opción.

El IBM 701 es considerado como el primer superordenador en la Historia. Cómo se compara su velocidad con la de los superordenadores actuales.